Med fremskridt inden for elektronik og neurovidenskab har forskere været i stand til at opnå bemærkelsesværdige ting med hjerneimplantationsenheder, såsom at gendanne en synsfasthed for de blinde. Ud over at gendanne fysiske sanser søger forskere også innovative måder at lette kommunikation for dem, der har mistet evnen til at tale. En ny "dekoder", der modtager data fra elektroder, der er implanteret inde i kraniet, for eksempel, kan hjælpe lammede patienter med kun at tale med deres sind.

Forskere fra University of California, San Francisco (UCSF) udviklede en totrinns metode til at omdanne hjernesignaler til computersyntetiseret tale. Deres resultater, der blev offentliggjort denne uge i det videnskabelige tidsskrift Nature, giver en mulig vej mod mere flydende kommunikation for mennesker, der har mistet evnen til at tale.

I årevis har forskere forsøgt at udnytte neurale input for at give en stemme tilbage til mennesker, hvis neurologiske skader forhindrer dem i at tale - som slagtilfælde eller ALS-patienter. Indtil nu har mange af disse hjernecomputergrænseflader fremhævet en bogstav-til-bogstav-tilgang, hvor patienter bevæger deres øjne eller ansigtsmuskler for at udtale deres tanker. (Stephen Hawking dirigerede berømt sin talesynthesizer gennem små bevægelser i kinden.)

Men disse typer grænseflader er træg - de fleste producerer maks. 10 ord pr. Minut, en brøkdel af menneskers gennemsnitlige talehastighed på 150 ord pr. Minut. For hurtigere og mere flydende kommunikation brugte UCSF-forskere dybe indlæringsalgoritmer til at omdanne neurale signaler til talte sætninger.

”Hjernen er intakt hos disse patienter, men neuronerne - de veje, der fører til dine arme, eller din mund eller dine ben - er nedbrudt. Disse mennesker har høj kognitiv funktion og evner, men de kan ikke udføre daglige opgaver som at bevæge sig rundt eller sige noget, ”siger Gopala Anumanchipalli, co-lead forfatter af den nye undersøgelse og en associeret forsker med speciale i neurologisk kirurgi ved UCSF. ”Vi omgår i det væsentlige den sti, der er nedbrudt.”

Forskerne startede med højopløsningsdata om hjerneaktivitet indsamlet fra fem frivillige over flere år. Disse deltagere - som alle havde normal talefunktion - gennemgik allerede en overvågningsproces for epilepsibehandling, der involverede implantering af elektroder direkte i deres hjerner. Changs team brugte disse elektroder til at spore aktivitet i talerelaterede områder i hjernen, da patienterne læste hundreder af sætninger.

Herfra arbejdede UCSF-teamet en to-trins proces til at genskabe de talte sætninger. Først oprettede de en dekoder til at fortolke de indspillede hjerneaktivitetsmønstre som instruktioner til bevægelse af dele af en virtuel vokalveje (inklusive læber, tunge, kæbe og strubehoved). De udviklede derefter en synthesizer, der brugte de virtuelle bevægelser til at producere sprog.

Anden forskning har forsøgt at afkode ord og lyde direkte fra neurale signaler og springe over det midterste trin i afkodningsbevægelsen. Imidlertid antyder en undersøgelse, som UCSF-forskerne offentliggjorde sidste år, at din hjernes talecenter fokuserer på, hvordan man flytter vokalvejen til at producere lyde, snarere end hvad de resulterende lyde vil være.

”Mønstrene for hjerneaktivitet i talecentrene er specifikt rettet mod at koordinere bevægelserne i stemmekanalen, og kun indirekte knyttet til selve tale lyder, ” Edward Chang, professor i neurologisk kirurgi ved UCSF og medforfatter til det nye papir, sagde det i en pressemeddelelse i denne uge. "Vi prøver eksplicit at afkode bevægelser for at skabe lyde i modsætning til direkte afkodning af lydene."

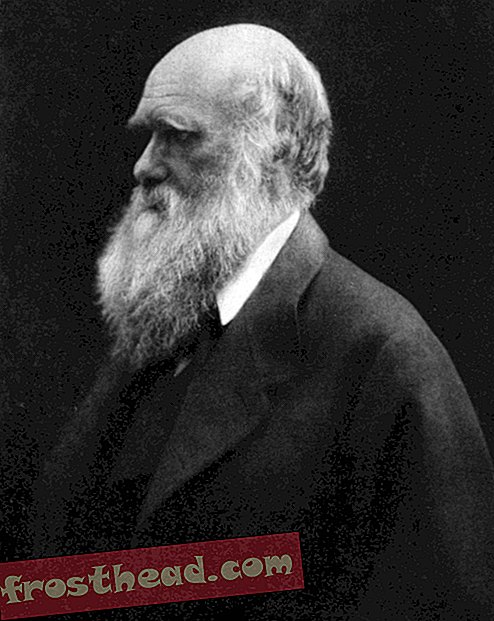

Et eksempel på hjerneimplantat-array af intrakranielle elektroder af den type, der bruges til at registrere hjerneaktivitet. (UCSF)

Et eksempel på hjerneimplantat-array af intrakranielle elektroder af den type, der bruges til at registrere hjerneaktivitet. (UCSF) Ved hjælp af denne metode har forskerne med succes omvendt konstrueret ord og sætninger fra hjerneaktivitet, der omtrent svarede til lydoptagelserne af deltagernes tale. Da de bad frivillige på en online crowddsourcing-platform om at forsøge at identificere ordene og omskrive sætninger ved hjælp af en ordbank, kunne mange af dem forstå den simulerede tale, skønt deres nøjagtighed langt fra var perfekt. Ud af 101 syntetiserede sætninger blev omkring 80 procent perfekt transkriberet af mindst en lytter ved hjælp af en 25-ord bank (denne sats faldt til ca. 60 procent, når ordbankens størrelse blev fordoblet).

Det er svært at sige, hvordan disse resultater sammenlignes med andre syntetiserede taleundersøgelser, siger Marc Slutzky, en nordvestlig neurolog, der ikke var involveret i den nye undersøgelse, i en e-mail. Slutzky arbejdede for nylig på en lignende undersøgelse, der producerede syntetiserede ord direkte fra cerebrale cortex-signaler uden at afkode bevægelse af vokalveje, og han mener, at den resulterende talekvalitet var lignende - skønt forskelle i præstationsmetrikker gør det svært at sammenligne direkte.

Et spændende aspekt af UCSF-undersøgelsen er imidlertid, at dekoderen kan generalisere nogle resultater på tværs af deltagerne, siger Slutzky. En stor udfordring for denne type forskning er, at træning af dekoderalgoritmerne normalt kræver, at deltagerne taler, men teknologien er beregnet til patienter, der ikke længere kan tale. At være i stand til at generalisere noget af algoritmens træning kunne muliggøre yderligere arbejde med lammede patienter.

For at tackle denne udfordring testede forskerne også enheden med en deltager, der lydløst efterlignede sætningerne i stedet for at tale dem højt. Selvom de resulterende sætninger ikke var så nøjagtige, siger forfatterne, at syntese var mulig, selv uden vokaliseret tale, har spændende implikationer.

”Det var virkelig bemærkelsesværdigt at finde ud af, at vi stadig kunne generere et lydsignal fra en handling, der slet ikke genererede lyd, ” sagde Josh Chartier, en medforfatter for studiet og bioingeniørstuderende ved UCSF. .

Billede af undersøgelsesforfatter Gopala Anumanchipalli, ph.d., der holder et eksempel på en række intrakranielle elektroder af den type, der blev brugt til at registrere hjerneaktivitet i den aktuelle undersøgelse. (UCSF)

Billede af undersøgelsesforfatter Gopala Anumanchipalli, ph.d., der holder et eksempel på en række intrakranielle elektroder af den type, der blev brugt til at registrere hjerneaktivitet i den aktuelle undersøgelse. (UCSF) Et andet mål for fremtidig forskning er at forfølge demonstrationer i realtid af dekoderen, siger Anumanchipalli. Den aktuelle undersøgelse var ment som et bevis på koncept - dekoderen blev udviklet separat fra dataindsamlingsprocessen, og teamet testede ikke realtidshastigheden for at oversætte hjerneaktivitet til syntetiseret tale, selvom dette ville være det eventuelle mål med en klinisk enhed.

Denne syntese i realtid er noget, der skal forbedres for, at en sådan enhed kan være nyttig i fremtiden, siger Jaimie Henderson, en neurokirurg i Stanford, der ikke var involveret i undersøgelsen. Stadig siger han, at forfatternes to-trins metode er en spændende ny tilgang, og brugen af dyb læringsteknologi kan give ny indsigt i, hvordan tale virkelig fungerer.

”For mig er bare ideen om at begynde at undersøge det underliggende grundlag for, hvordan tale produceres hos mennesker, meget spændende, ” siger Henderson. "[Denne undersøgelse] begynder at udforske en af vores mest menneskelige evner på et grundlæggende niveau."