Afhængigt af hvordan du tæller dem, er det menneskelige ansigt drevet af mellem 23 og 43 muskler, hvoraf mange fastgøres til huden, hvilket ikke tjener nogen åbenbar funktion til at overleve. En udlænding, der undersøger et menneskeligt eksemplar isoleret, ville ikke vide, hvad de skal lave af dem. Trækker på panden, øjenbryn, læber og kinder, udsender musklerne et væld af informationer om vores følelsesmæssige tilstand, niveau af interesse og årvågenhed. Det er et bemærkelsesværdigt effektivt kommunikationsmiddel - næsten øjeblikkelig, normalt nøjagtig, overskrider de fleste sproglige og kulturelle barrierer. Men nogle gange går dataene tabt, ignoreres eller fejlagtigt fortolket. Hvis en tømmerhugger smiler i skoven uden at være i nærheden for at se ham, var han faktisk glad?

Fra denne historie

[×] LUKKET

Så lange humørikoner. Forskeren udvikler teknologi, der kan registrere og læse vores udtryk

Video: Smithsonian Ingenuity Awards 2015: Rana el Kaliouby

Relaterede læser

Følelsesmæssig intelligens: Hvorfor det kan være mere vigtigt end IQ

KøbeRana el Kaliouby hader at se, at information går til spilde. Når jeg møder el Kaliouby på sit lille kontor i Waltham, Massachusetts, ser jeg hende samle hendes zygomaticus store muskel, hæve hjørnerne i hendes mund og hendes orbicularis oculi og krøller de ydre hjørner af øjnene. Hun smiler, og jeg udleder, at hun byder mig velkommen, inden hun endda får ordet ”hej”. Men mange sociale udvekslinger i dag finder sted uden real-time ansigt til ansigt-interaktion. Det er her el Kaliouby og hendes firma kommer ind.

El Kaliouby, som er 37, smiler ofte. Hun har et rundt, behageligt, udtryksfuldt ansigt og en solicit måde, der binder sin position som medstifter af en hurtigt voksende tech-opstart - en anti-Bezos, en un-Zuckerberg. Hendes firma, Affectiva, som hun grundlagde i 2009 med en daværende kollega ved MIT Media Lab, Rosalind Picard, indtager en position i forkant med teknologien til at bruge computere til at opdage og fortolke menneskelige ansigtsudtryk. Dette felt, kendt som "affektiv computing", søger at lukke kommunikationsgabet mellem mennesker og maskiner ved at tilføje en ny måde at interagere på, inklusive smilets, smirks og hævede øjenbryns ikke-verbale sprog. ”Forudsætningen for, hvad vi gør, er, at følelser er vigtige, ” siger el Kaliouby. ”Følelser forstyrrer ikke vores rationelle tanker, men vejleder og informerer den. Men de mangler i vores digitale oplevelse. Din smartphone ved, hvem du er, og hvor du er, men den ved ikke, hvordan du har det. Vi sigter mod at ordne det. ”

Hvorfor har din smartphone brug for at vide, hvordan du har det? El Kaliouby har en række svar, alt sammen baseret på den tilsyneladende ubegrænsede integration af computere i rutinerne i vores daglige liv. Hun ser for sig ”teknologi til at kontrollere belysning, temperatur og musik i vores hjem som svar på vores humør, ” eller apps, der kan tilpasse indholdet af en film baseret på dine underbevidste reaktioner på den, mens du ser. Hun forestiller sig programmer, der kan overvåge dit udtryk, mens du kører og advarer om uopmærksomhed, døsighed eller vrede. Hun smiler til omtale af sin yndlingside - ”et køleskab, der kan sanse, når du er stresset og låser isen op.”

Især mener hun, at Affectiva, og teknologien, det er med til at indlede i mainstream, vil være en velsignelse for sundhedsvæsenet. En forsker, der tester et nyt lægemiddel, eller en terapeut, der behandler en patient, får kun feedback med intervaller, underlagt alle problemer med selvrapportering - det ubevidste ønske om at behage lægen, for eksempel eller selektiv erindring, der favoriserer de seneste erindringer . El Kaliouby ser for sig et program, der kører i baggrunden af motivets bærbare computer eller telefon, der kan udarbejde et øjeblik-til-øjeblik-optagelse af hans eller hendes humør i løbet af en periode (en dag, en måned) og korrelere den med tid eller noget andet, din enhed kan måle eller spore. ”Det behøver ikke engang at være en del af et behandlingsprogram, ” konstaterer hun. "Du kunne bare have det på din telefon, og det fortæller dig, hver gang 'X' ringer har du et negativt udtryk, og det fortæller dig noget, du måske ikke har kendt."

Abonner på Smithsonian magasin nu for kun $ 12

Denne historie er et udvalg fra decemberudgaven af Smithsonian magasinet.

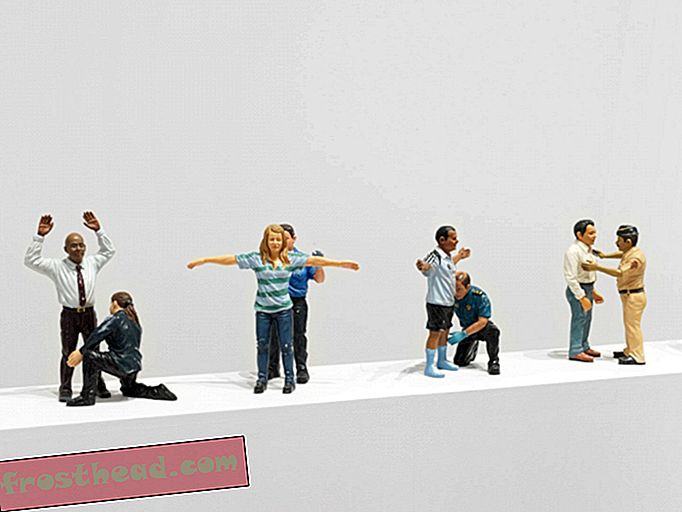

KøbeEl Kaliouby fremmer affektiv computing som det logiske næste trin i progressionen fra tastatur til mus til berøringsskærm til stemmegenkendelse. I foråret udgav Affectiva sit første kommercielle softwareudviklingssæt, som udviklere, der er interesseret i brugernes realtids-følelsesmæssige tilstande, kan inkorporere i deres egne programmer - f.eks. Musikafspillere eller spil eller dating apps. Og netop i efteråret lancerede Affectiva Emotion As a Service, et skybaseret program, hvortil kunder kan uploade videoer til analyse. Hvem bruger måske dette? En kandidat, der er ved at blive interviewet til et job, der er bekymret for at fremstå ængstelig eller keder sig eller endda smile for meget. Eller et flyselskab, der ansætter flyvende, med hundredevis af videoapplikationer, der skal sigtes igennem på jagt efter dem, der kan klare et overbevisende smil, når de byder farvel til passagererne. (Et ægte smil, der involverer en sammentrækning af musklerne i hjørnene af øjnene, kaldes et "Duchenne" smil, opkaldt til det 19. århundrede anatomist; det modsatte, et tvunget smil, der bruger bare munden, er faktisk undertiden kaldte et "Pan Am" smil.)

Og selvfølgelig er enhederne, der kører denne software, alle forbundet til Internettet, så de oplysninger, de indsamler, øjeblikkeligt samles, sigtes og netværk på den måde, som sociale medie-apps identificerer populære emner eller personligheder. Samlet, måske, til noget som et Affectiva-humørindeks, en numerisk læsning om den grove nationale lykke eller opdelt i regioner, hvor smil eller ridser i øjeblikket er trend.

Affectivas grundlæggende program analyserer ansigtet 20 gange pr. Sekund for 46 lokaliserede udtryk for lykke, tristhed, overraskelse, frygt, vrede, afsky og foragt, plus interesse og forvirring. (Naomi Shavin / Smithsonian)

Affectivas grundlæggende program analyserer ansigtet 20 gange pr. Sekund for 46 lokaliserede udtryk for lykke, tristhed, overraskelse, frygt, vrede, afsky og foragt, plus interesse og forvirring. (Naomi Shavin / Smithsonian) Indtil nu har Affectivas største kunder været reklame-, marketing- og medievirksomheder. Dens software automatiserer processen med at køre en fokusgruppe, det besværlige ritual at samle et dusin mennesker i et rum for at give deres mening om et nyt produkt, tv-serie eller annoncekampagne; det registrerer reaktioner direkte, uden at en deltager er nødt til at twiddle en urskive eller besvare et spørgeskema som svar på en præsentation. Desuden udvider softwaren den potentielle fokusgruppe til hele verden eller i det mindste den betydelige brøkdel af den, der har en webcam-aktiveret computer eller mobil enhed.

Feedback fra Affectivas ubarmhjertige, alt-seende øje hjalp med til at forme en netværk-tv-sitcom og overførte to karakterer til glemmebogen for synden ved ikke at få seerne til at smile. (El Kaliouby identificerer ikke showet eller karaktererne.) Dens software blev brugt til at opbygge en "smile sampler", en maskine, der uddelte slikbarer til shoppere, der smilede ind i sit kamera. Med mere forskning kan det sandsynligvis være nyttigt til tilsyn med mængder i lufthavne eller til at identificere potentielle butiksliftere eller som en løgnedetektor.

Men el Kaliouby har modstået disse surreptitious applikationer, hvor lukrative de måtte være. Hun mener, at affektiv computing vil ændre verden, inklusive, men på ingen måde begrænset til, at sælge candy barer. ”Vores virksomheds etos, ” siger hun, ”er at bruge denne teknologi til at forbedre folks liv og hjælpe dem med at kommunikere bedre, ikke kun for at hjælpe annoncører med at sælge flere produkter.”

**********

I modsætning til mange tech-iværksættere var det at blive rig ikke på el Kalioubys oprindelige dagsorden. Født i Kairo for egyptiske forældre, der begge arbejder inden for teknologi, studerede hun datalogi ved det amerikanske universitet i Kairo, hvor hun uddannede sig i 1998, omkring det tidspunkt computere blev stærke nok til, at forskere kunne tænke på at give dem det, der på menneskelig vis er kaldet følelsesmæssig intelligens.

Hun fortsatte med at studere datalogi på University of Cambridge og ankom lige efter angrebene på Amerika den 11. september 2001. Hendes forældre troede, at hun risikerede at blive arresteret, chikaneret eller værre på grund af hendes arv. Men selv om hun bar en muslimsk hovedbeklædning indtil for et par år siden, hverken i Cambridge, England eller i Cambridge, Massachusetts, hvor hun flyttede i 2006 for at deltage i MIT Media Lab, var hun nogensinde bekymret over sin religion eller udseende . ”Jeg tror, det er fordi jeg smiler meget, ” siger hun og smiler.

Den franske anatomist Duchenne offentliggjorde milepæleundersøgelser af menneskelige ansigtsudtryk. (Bridgeman-billeder)

Den franske anatomist Duchenne offentliggjorde milepæleundersøgelser af menneskelige ansigtsudtryk. (Bridgeman-billeder) Mens hun var i Cambridge, var hun interesseret i problemet med autisme, nærmere bestemt den vanskelighed, som autistiske børn har med at læse ansigtsudtryk. Hun foreslog at bygge et ”følelsesmæssigt høreapparat”, der kunne bæres til at læse ansigter og give en passende opførsel til bæreren. Først blev afvist for et tilskud fra National Science Foundation med den begrundelse, at projektet var for vanskeligt, hun og hendes kolleger byggede en prototype bestående af et par briller udstyret med et lille kamera, blinkende lys og en hovedtelefon, ikke i modsætning til en tidlig version af Google Glass. En anden tilskudsansøgning var vellykket, og efter at hun flyttede til MIT, arbejdede hun og hendes team i de næste tre år for at perfektionere og teste den på en skole i Rhode Island. El Kaliouby beskriver det som ”et forskningsprojekt og et vellykket projekt” - de autistiske børn, der brugte det, havde overvældende positive oplevelser - men i 2008, da bevillingen sluttede, stod hun overfor et øjeblik med at regne. Den kommercielle interesse for affektiv computing voksede, og hun ønskede at se det udvide og blomstre; at lægge hendes indsats på at udvikle brillerne ville begrænse det til en lille skive af dens potentielle anvendelser. Så sammen med Picard, slukede hun Affectiva, mens hun holdt håb om, at et andet firma ville hente det følelsesmæssige høreapparat og bringe det på markedet.

Da Affectiva blev dannet, valgte den håndfulde "teammedlemmer", der udgjorde virksomheden, hver en værdi, de ønskede at legemliggøre, såsom "læring" eller "socialt ansvar" eller "sjovt." Hers, som chefstrategi og videnskabsmedarbejder, var "lidenskab." Den 20-personers virksomhed drives som et kvasi-demokrati med halvårlige møder, hvor medarbejderne stemmer om prioriteter, de skal forfølge i de næste seks måneder. Hendes kontor har et tavle dækket med tegninger af den unge datter af en af hendes kolleger; hun har en 6-årig søn, Adam, og en 12-årig datter, Jana, der bor sammen med hende i Boston-forstæderne (deres far bor i Egypten). Hendes måde er mild og hensynsfull; en time ind om morgenmødet tilbyder hun at bestille en sandwich til en besøgende, selvom hun selv springer frokost over. ”Det er Ramadan for mig, ” siger hun og smiler, ”men det er ikke Ramadan for dig.”

Hun sæder besøgende ved et skrivebord, vender mod en skærm og et webcam; softwaren finder besøgerens ansigt og tegner en kasse rundt om det på skærmen. Den identificerer et sæt punkter, der skal spores: hjørnerne i øjne og mund, spids af næsen, og så videre. Tyve gange hvert sekund søger softwaren efter ”action-enheder”, det ofte flygtige spil med muskler over ansigtet. Der er 46 af disse, i henhold til standardsystemet for klassificering, Facial Action Coding System (FACS). De inkluderer indvendige og udvendige øjenvipper, dimplers, blink, blink og læbe-puckere, tragters, pressere og suger. Affectivas standardprogram prøver omkring 15 af disse til enhver tid og analyserer dem for udtryk for syv grundlæggende følelser: lykke, tristhed, overraskelse, frygt, vrede, afsky og foragt, plus interesse og forvirring. Smil, og du kan se målene for lykke skyde op; krøll din læbe i en latter og programmet bemærker din afsky.

Eller mere præcist dit udtryk for afsky. Hele forudsætningen for affektiv computing hviler på, hvad der svarer til et sprang af tro, at et smil formidler en følelse af lykke, glæde eller underholdning. Naturligvis er mennesker i samme position: Vi kan narre af et falskt smil eller forvirret vrede, så vi kan ikke rigtig forvente mere af et computerprogram, i det mindste endnu ikke.

Over tid har Affectiva bygget et arkiv med mere end tre millioner videoer af ansigter, uploadet af internetbrugere rekrutteret fra omkring 75 lande over hele verden. Hundrede tusinder af disse er blevet analyseret af uddannede observatører og kodet til FACS-handlingsenheder - en monumental virksomhed, da videoerne i gennemsnit er omkring 45 sekunder og det tager cirka fem gange så lang tid at behandle. Resultaterne fra de menneskelige kodere blev til gengæld brugt til at ”træne” virksomhedens algoritmer, der behandlede resten i realtid. Hele databasen omfatter nu omkring 40 milliarder “følelsesdatapunkter”, en ressource, som El Kaliouby kan prale af, der adskiller Affectiva fra andre virksomheder på det samme felt, såsom Californien-baserede Emotient, sandsynligvis dens nærmeste konkurrent.

(Diagram: 5W Infographics; Kilde: Daniel McDuff, MIT Media Lab, Affectiva)

(Diagram: 5W Infographics; Kilde: Daniel McDuff, MIT Media Lab, Affectiva) Daniel McDuff, der tiltrådte Affectiva fra MIT Media Lab og fungerer som direktør for forskning, studerer kontinuerligt denne trove for yderligere indsigt i udtryk for følelser. Hvordan adskiller de sig efter alder, køn og kultur? (McDuff har måske overraskende fundet, at ældre mennesker er mere udtryksfulde, især af positive følelser, end yngre.) Kan vi pålideligt måle foragt, forlegenhed, kedsomhed, angst? Hvornår signaliserer en brynefure en forvirring, og hvornår angiver det koncentration? Hvordan kan vi skelne mellem et udtryk for frygt og et, der betyder overraskelse? (Tip: Handlingsenhed 1, den "indvendige brow raiser", er markøren for frygt; handling unit 2, "den ydre brow raiser", indikerer overraskelse.) Der er, siger han, al grund til at tro, at programmet vil fortsætte at blive bedre til at opdage udtryk (selvom det måske aldrig helt overvinder den største hindring af alle: Botox).

På min anmodning gav McDuff programmet et af de store klassiske problemer med følelsesdetektering, Mona Lisa, hvis gåtefulde kvasi-smil har fascineret seerne i 500 år. Med det advarsel om, at softwaren fungerer bedst med at skifte udtryk, ikke statiske billeder, rapporterede han, at den ikke fandt noget bevis på et ægte smil fra La Gioconda, men snarere en kombination af handlingsenhed 28 (læberulle) og 24 (læber presset sammen), hvilket muligvis antyder et vist niveau af ubehag.

**********

”Jeg taler med dig nu, ” siger el Kaliouby, ”og ser på dig for at måle din interesse for hvad jeg siger. Skal jeg bremse og forklare mere? Skal jeg gå til et andet emne? Forestil dig nu, at jeg giver et webinar til en stor gruppe, som jeg ikke kan se eller høre. Jeg får ingen feedback, der er ingen måde at fortælle, om en joke arbejdede eller faldt fladt, hvis folk er engagerede eller keder sig. Ville det ikke være dejligt at få denne feedback i realtid, samlet, fra øjeblik til øjeblik, når jeg går sammen? ”

Hun spiller en annonce for Jibo, en "social robot", der er tilgængelig til forudbestilling på crowd-finansieringswebstedet Indiegogo og udviklet af en tidligere MIT-kollega, Cynthia Breazeal. Ser ud som en højteknologisk lavalampe, sidder Jibo på et bord og scanner omgivelserne, identificerer enkeltpersoner ved ansigt og interagerer med dem - videresender beskeder, udsender påmindelser, foretager rutinemæssige telefonopkald, endda chatter. Dette er en anden potentiel applikation til Affectivas software - virksomhederne er i samtaler - og det er "et meget spændende udsigt, " siger el Kaliouby.

Spændende for nogle, men udsigten til følelsesbehandlingsroboter er alarmerende for andre. Sherry Turkle, der længe har undersøgt, hvordan mennesker forholder sig til computere, advarer i sin nye bog, Reclaiming Conversation: The Power of Talk in a Digital Age, om det "robotiske øjeblik", når maskiner begynder at erstatte det menneskelige selskab. Turkle mener, at forskere som el Kaliouby og hendes team kan gøre, hvad de siger, de vil. ”Dette er alle strålende, begavede mennesker, der laver strålende arbejde, ” siger hun. Og hun er enig i, at i bestemte sammenhænge - farlige miljøer, såsom det ydre rum eller omkring tunge maskiner, hvor du vil indrømme enhver mulig kommunikationsform - har affektiv computing en rolle at spille. ”Men det næste trin, ” siger hun, ”følger slet ikke. Det næste trin er, lad os få en robotven. Jeg har interviewet forældre, der er glade for, at deres børn taler med Siri, og jeg tror, det ikke fører os ned ad en vej, hvor vi vil hen. Vi definerer os selv som mennesker ud fra hvem vi forbinder med, og det giver ingen mening for mig at danne din følelse af selvværd i relation til en maskine. Hvorfor vil du have en computer til at vide, om du er trist? ”

Selv el Kaliouby er tilbøjelig til at være enig i, at "vi bruger mere tid, end vi burde med vores enheder, " når hun naturligvis tænker hendes preteen datter, hvis blik låser fast på hendes smartphone-skærm.

Men hun betragter tendensen mod stadig større tilslutningsmuligheder som irreversibel, og hun mener, at selv om brugerne altid skulle være nødt til at tilmelde sig, kan vi lige så godt gøre det bedste ud af det. Hun forudser, at vores enheder vil have "en følelseschip og en pakke apps, der bruger den på en måde, der tilføjer tilstrækkelig værdi til vores liv, der opvejer folks bekymringer ved at dele disse data." Hun tegner en analogi til GPS-enheder: Affektiv computing kan hjælpe os med at navigere i følelsesmæssigt rum på samme måde som telefonapps hjælper os med at komme rundt i det fysiske rum. ”Alle var bekymrede over lokaliseringsfølende enheder, da de også først kom ud: De invaderede vores privatliv, de sporer os hele tiden, ” siger hun. ”Først nu ville vi alle gå tabt uden Google Maps på vores telefoner. Jeg tror, det vil være det samme. ”

**********