Vi ved alle, at der er meget mere information i vores verdener, end der tidligere var. Hvad angår hvor meget mere, ja, de fleste af os er temmelig usikre.

Relateret indhold

- Infographics gennem tiderne Fremhæv videnskabens visuelle skønhed

- Hvorfor Google Flu Trends ikke kan spore influenza (endnu)

Her er en uvurderlig nugget om al den info, komplimenter af Dave Turek, den fyr, der har ansvaret for supercomputer-udvikling hos IBM: Fra år 2003 og arbejder bagud til begyndelsen af den menneskelige historie genererede vi ifølge IBMs beregninger fem exabyte - det er fem milliarder gigabyte - med information. Sidste år var vi ved at uddrive så mange data hver anden dag. I næste år, forudsiger Turek, gør vi det hvert 10. minut.

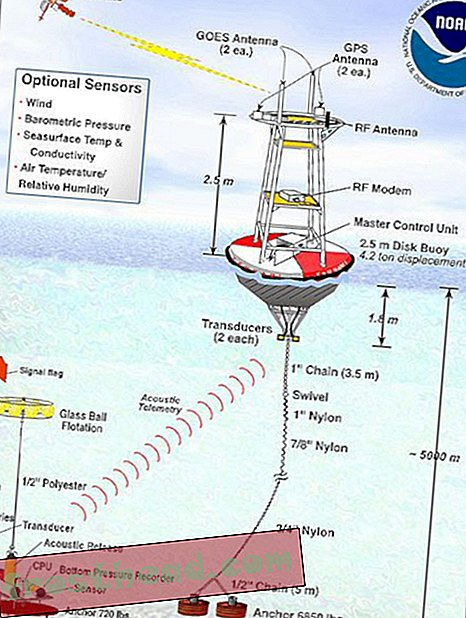

Men hvordan er dette muligt? Hvordan blev data sådan digital kudzu? Enkelt sagt, hver gang din mobiltelefon sender sin GPS-placering, hver gang du køber noget online, hver gang du klikker på Like-knappen på Facebook, lægger du en anden digital besked i en flaske. Og nu er oceanerne stort set dækket med dem.

Og det er kun en del af historien. Tekstmeddelelser, kundeposter, ATM-transaktioner, billeder af sikkerhedskameraer ... listen fortsætter og fortsætter. Buzzword for at beskrive dette er "Big Data", skønt det næppe retfærdiggør omfanget af det monster, vi har oprettet.

Det er det nyeste eksempel på teknologi, der overskrider vores kapacitet til at bruge den. I dette tilfælde er vi ikke begyndt at indhente vores evne til at indsamle information, og det er derfor, at en favorit trop af ledelsesundersøgere i disse dage er, at fremtiden hører til virksomheder og regeringer, der kan give mening om alle de data, de er indsamling, helst i realtid.

Virksomheder, der kan fortolke enhver digital brødkrumm, som deres kunder efterlader, vil have en fordel, tankegangen går - ikke bare hvem der har købt hvad hvor i den sidste time - men om de twitret om det eller udgav et foto et sted i virvel af sociale netværk. Det samme gælder de byer, der kan indsamle data fra de tusinder af sensorer, der nu prikker bylandskaber og forvandler bylivets ujævnheder, såsom trafikflow, til en videnskab.

Ikke overraskende tager politiske kampagner allerede springet og rasende minedrift af data som en del af deres fokus på at "nanotargete" vælgere, så de ved nøjagtigt, hvordan de skal sætte dem op for deres stemmer og penge. Blandt de konklusioner, som analytikere har draget, er ifølge New York Times- spaltist Thomas Edsall, at republikanere viser en præference for restauranterne "The Office" og Cracker Barrel, mens demokraterne er mere tilbøjelige til at se "Late Night With David Letterman" og spise på Chuck E Ost.

Dette hast med at fortolke digital flotsam forklarer, hvorfor Google i sidste uge annoncerede, at det vil begynde at sælge et produkt, det kalder BigQuery, software, der kan scanne terabyte af information på få sekunder. Og hvorfor en start ved navn Splunk, som har teknologi, der kan analysere enorme mængder af kunde- og transaktionsdata, så værdien af dens aktier stige næsten 90 procent den dag, den gik offentlig i sidste måned. Dette for et firma, der tabte $ 11 millioner sidste år.

Dataforskerens stigning

Men selv adgang til de bedste data-dechiffreringsværktøjer er ingen garanti for stor visdom. Meget få virksomheder har personer, der har uddannelse, ikke kun til at evaluere bjerge af data - inklusive masser af ustrukturerede småting fra millioner af Facebook-sider og smarttelefoner - men også for faktisk at gøre noget med det.

Sidste år udsendte McKinsey Global Insitute en rapport, der beskrev "Big Data" som "næste grænse for innovation", men forudsagde også, at virksomheder i USA i 2018 vil have en alvorlig mangel på talent, når det kommer til de nødvendige analytiske færdigheder - lige så mange 190.000 mennesker. Og det hævder, at yderligere 1, 5 millioner ledere skal trænes til at træffe strategiske beslutninger med strømmen af data, der kommer deres vej.

Ikke alle er dog tro på magien i Big Data. Peter Fader, professor i marketing ved Penn's Wharton School of Business, er ikke overbevist om, at flere data er bedre. Ikke at han mener, at en virksomhed ikke burde prøve at lære så meget som det kan om sine kunder. Det er bare det, at der nu er så meget fokus på at samle hver bit af data, som han mener, at volumen er værdsat frem for sand analyse.

Her er Fader fra et nyligt interview med MIT's Technology Review: ”Selv med uendelig viden om fortidens opførsel har vi ofte ikke nok information til at komme med meningsfulde forudsigelser om fremtiden. Faktisk, jo flere data vi har, jo mere falsk tillid vil vi have ... Den vigtige del er at forstå, hvad vores grænser er, og at bruge den bedst mulige videnskab til at udfylde hullerne. Alle data i verden vil aldrig nå det mål for os. ”

Hvem er dine data?

Her er en stikprøve af, hvordan Big Data bruges til at løse store problemer:

- De ved, hvornår de har været dårlige eller gode: Mens de fleste virksomheder fokuserer på at analysere deres kunder, scorer Amazon point ved hjælp af Big Data til at hjælpe dem.

- Undersøgelsen af stutterier: Vil du vide, hvilke tyre, der gyder de mest produktive mælkekøer? Mejeriindustrien har udtænkt en måde at knuse tallene på.

- Diagnostik ved hjælp af data: Forskere ved SUNY Buffalo analyserer massive datasæt i deres bestræbelser på at bestemme, om der er en forbindelse mellem multippel sklerose og miljøfaktorer, som for eksempel ikke tilstrækkelig eksponering for sollys.

- På udkig efter problemer: En virksomhed, der kaldes Record Future, er minedriftinfo fra sociale netværk og regerings- og finansielle websteder for at lave prognoser for, hvordan befolkningstilvækst, vandmangel og ekstrem vejr kan føre til fremtidig politisk uro og terrorisme.

Videobonus: At indsamle data er en ting. At få det til at se tiltalende og forståeligt ud er en helt anden udfordring. David McCandless vokser over kraften i "informationskort" i denne TED-tale.